OpenAI放大招!核心API支持MCP,一夜改变智能体开发

摘要

支持MCP后可集中管理工具,通过allowed_tools参数精确控制智能体访问工具,避免不必要的调用、上下文膨胀,缩短响应时间,还能让智能体按预设规则选择合适工具调用,提升效率。

MCP支持动态工具列表导入和缓存机制,智能体首次连接服务器时导入并缓存工具列表,后续调用直接使用缓存,减少延迟,提高响应速度。

开发者可在Responses API中直接访问OpenAI最新图像生成模型,如<gpt-image-1>,支持实时流传输、预览查看及多轮编辑,方便开发者精细调整图像。

Responses API可生成模型内部思维链的简洁自然语言摘要,便于调试、审计和优化用户体验;符合零数据保留条件的客户可重复使用推理项,无需存储在OpenAI服务器,降低成本和延迟。

今天凌晨,OpenAI全资收购io的消息占据了大部分头条。同时OpenAI也“悄悄地”放出了另外一个重磅消息,用于开发智能体的核心API——Responses API支持MCP服务。

传统方法,我们在开发智能体需要通过函数调用与外部服务交互,每次操作都涉及从大模型到后端再到外部服务的网络传输,导致多次跳转、延迟会很高,并增加扩展和管理的复杂性。

现在Responses API支持了MCP,开发者无需为每个函数调用手动连接特定服务,而是可以将模型配置为指向一个或多个MCP服务。

Responses API支持MCP

自OpenAI发布Responses API以来,已有数十万开发人员通过该API处理了数万亿token数据,并开发了各种各样的智能体应用,包括Zencoder的编码智能体、Revi 用于私募股权和投资银行的市场智能体,以及 MagicSchool AI的教育智能体。

为了进一步简化智能体开发,Responses API支持了MCP服务,开发人员只需几行代码即可将智能体连接到强大的外部工具和服务。

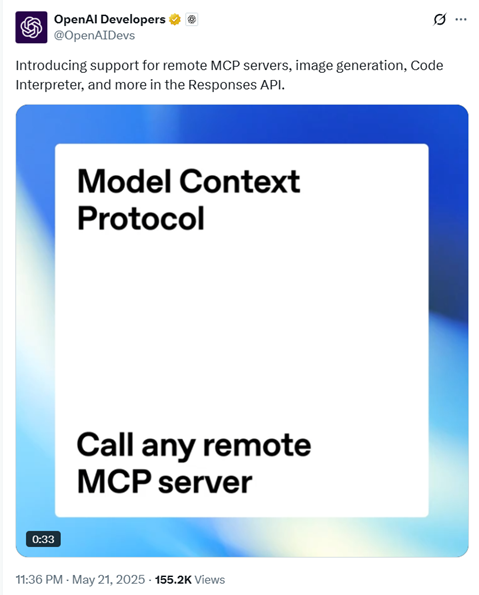

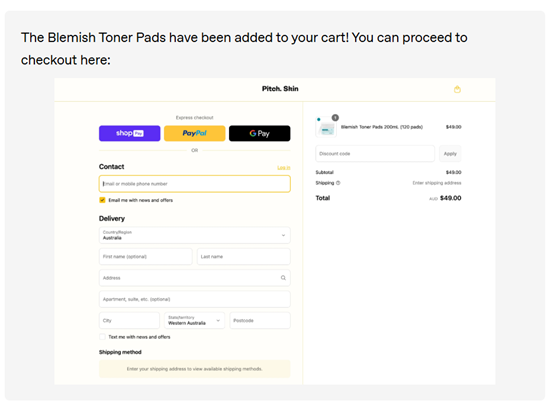

例如,只需要9行代码,就能将你的智能体链接到电商平台Shopify。

在过去,我们需要编写自定义cart_add或create_payment_link包装器并托管自己的中继服务器。现在全部简化了,一个指向轻松搞定。

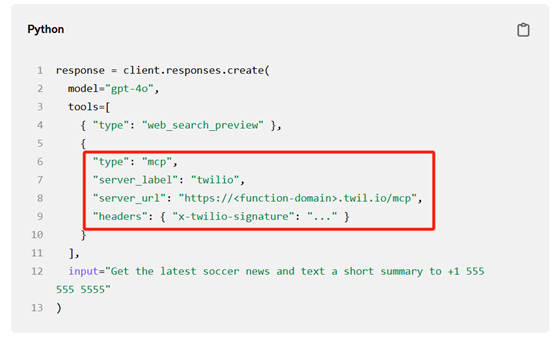

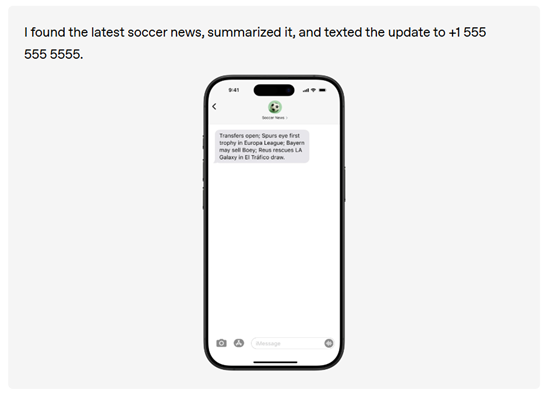

只用了13行代码将智能体连接到云通信平台Twilio。而之前,需要在你的后端中整合两个工具调用,并自行批处理最终的短信负载。

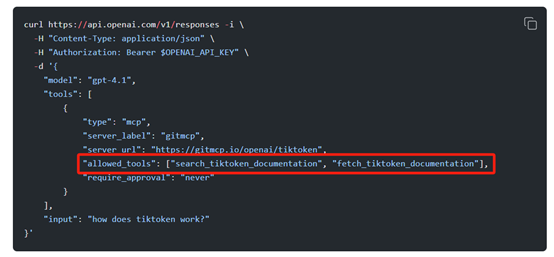

支持MCP后,还有一个好处就是可以集中管理工具,使得智能体能够高效地调用外部服务。我们可以使用allowed_tools 参数精确控制智能体能够访问的工具,从而避免不必要的工具调用、上下文膨胀以及缩短响应时间。

例如,在处理用户查询时,智能体可以根据预设的规则选择最合适的工具进行调用,而不是盲目地尝试所有可能的工具。

在使用MCP时,还可以通过精确的权限控制确保智能体的安全性。例如,可以限制智能体只能调用某些特定的工具,或者在调用工具时需要显式批准。这种权限控制机制不仅防止了智能体滥用工具,还保护了外部服务的安全性。

通过在每次调用中传递授权密钥和服务器 URL,MCP确保了身份验证和授权的安全性,同时避免了敏感信息在响应对象中的泄露。

此外,MCP支持动态工具列表的导入和缓存机制。当智能体首次连接到一个MCP服务器时,会从服务器导入工具列表,并将其缓存到模型上下文中。在后续的调用中,智能体可以直接使用缓存的工具列表,而无需再次从服务器获取,从而减少了延迟并提高了响应速度。

当然,支持MCP后还有很多其他好处,这里就不列举了,有兴趣的小伙伴可以自己去尝试一下,或者参加「AIGC开放社区」在线下举办的MCP公开课,为大家真实演示一下。

Responses API其他新增功能

除了支持MCP外,OpenAI 还对Responses API 中的图像生成、Code Interpreter 和文件搜索工具进行了重大更新,进一步增强了智能体的功能。

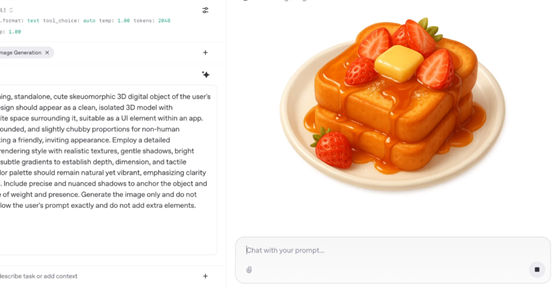

图像生成:开发者现在可以在Responses API 中直接访问 OpenAI 的最新图像生成模型(如 <gpt-image-1>),并将其作为工具使用。该工具支持实时流传输,允许开发者在图像生成过程中查看预览,并支持多轮编辑,使开发者能够逐步精细调整图像。

Code Interpreter:Code Interpreter 工具现在可以在 Responses API 中使用,支持数据分析、解决复杂的数学和编码问题,甚至帮助模型深入理解和操作图像。例如,在处理数学问题时,模型可以利用 Code Interpreter 运行代码来得出答案,从而显著提升性能。

文件搜索:文件搜索工具得到了增强,允许开发者根据用户查询将文档中的相关内容块提取到模型的上下文中。此外,该工具还支持跨多个向量存储执行搜索,并允许使用数组进行属性过滤。

同时OpenAI也在Responses API引入了全新的功能。

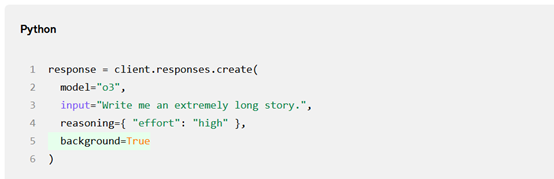

后台模式:对于需要较长时间处理的任务,开发者可以使用后台模式异步启动这些任务,而无需担心超时或其他连接问题。开发者可以通过轮询这些任务来检查是否完成,或者在需要时开始流式传输事件。

推理摘要:Responses API 现在可以生成模型内部思维链的简洁自然语言摘要。这使得开发者更容易调试、审计和构建更好的最终用户体验。

加密推理项:符合零数据保留(ZDR)条件的客户可以在 API 请求之间重复使用推理项,而无需将任何推理项存储在 OpenAI 的服务器上。这不仅提高了智能性,还减少了标记使用量,降低了成本和延迟。